科学者たちの発明・発見・研究・開発の恩恵を受けて生活は便利になり、豊かになり、進歩してきた。一方で、科学技術の軍事利用でかつてはなかった大きな損害や悲劇が生まれている。科学の表と裏、明と暗、善と悪…。いつの時代も語られてきた。

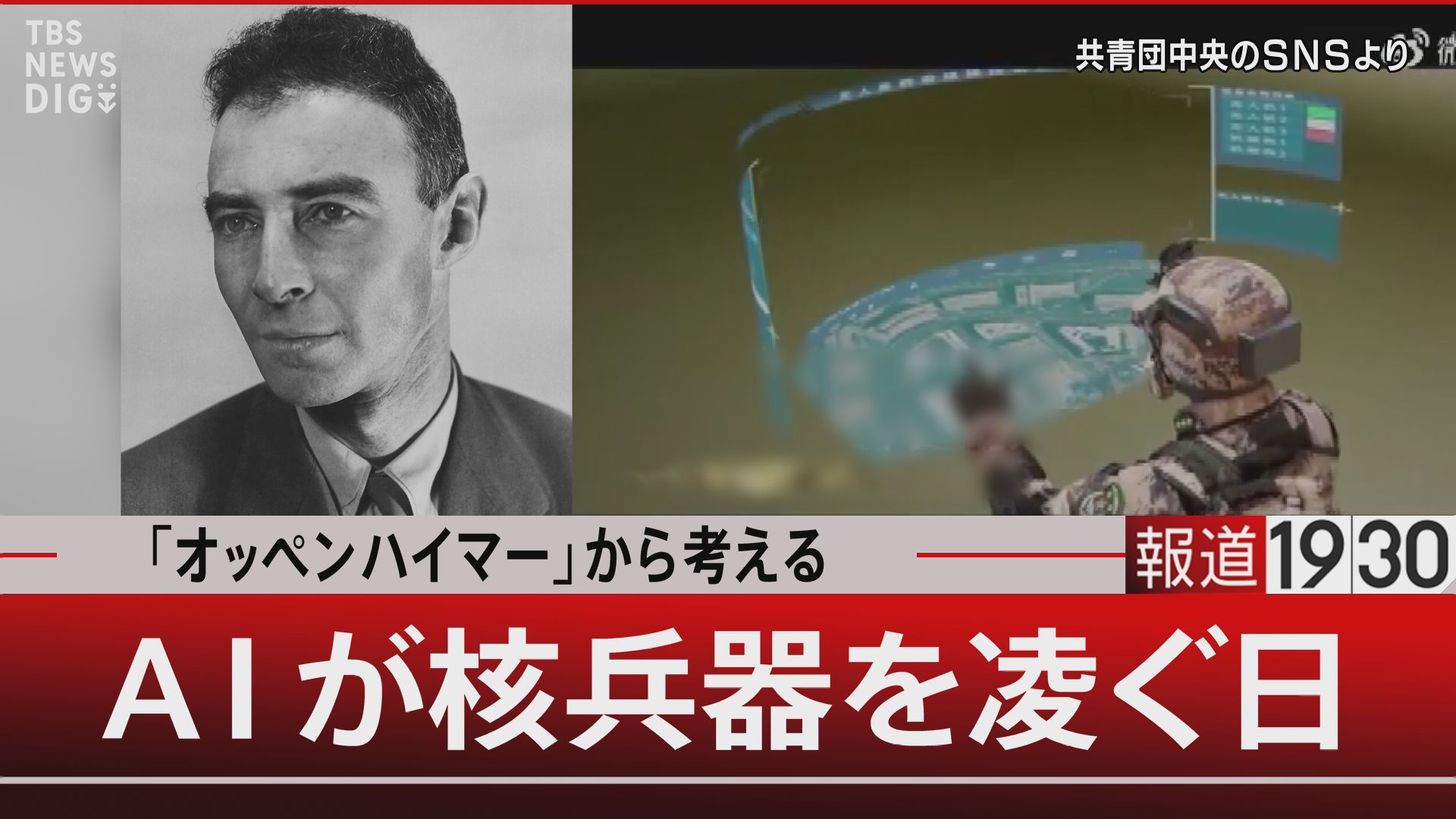

【写真を見る】映画「オッペンハイマー」から考える AIが核のボタンを持つ日…科学者の“性(さが)”【報道1930】

科学が戦争にもたらした革命。第1が“火薬”の登場、第2が“核”、そして第3が今直面している“AI”だ。『オープンAI』CEOのサム・アルトマン氏は「AIによる人類絶滅のリスクを軽減することは世界の優先事項であるべき」としている。急速に進歩するAIとその軍事利用。どう考えるべきか議論した。

「原子核のエネルギーを解放したら?物理学者だったら知りたいと思う」

第二次世界大戦下、かのアルベルト・アインシュタイン博士が時のアメリカ大統領に宛てた手紙がある。

「極めて強力な新型爆弾が製造されるかもしれない。アメリカも核分裂を研究する物理学者と緊密に連携し…」

この前にドイツが核開発を進めているという情報があった。つまり、ヒトラー率いるナチスより先にアメリカがそれに負けてはいけないとアインシュタインは提案したのだ。

かくして1942年、原爆を開発する極秘プロジェクト『マンハッタン計画』が始まる。

科学者・技術者5万人と20億ドルを超える予算が費やされ完成した2種類の原爆は、濃縮ウランを使ったリトルボーイが広島に、プルトニウムを使ったファットマンが長崎にそれぞれ投下された。

計画の中心となり“原爆の父”と呼ばれることになる科学者をジュリアス・ロバート・オッペンハイマーといった。

彼の仕事と苦悩を描いた映画は、今年のアカデミー賞で7冠に輝いた。

映画では原爆開発に対する葛藤、苦悩が描かれ、戦争を終わらせた英雄として大統領に讃えられた時「閣下、私の手は血塗られたように感じます」と返すシーンもあった。

が、一方で、踏みとどまることもできたのかもしれない。なぜなら彼が核実験を成功させる前にナチスドイツが降伏したからだ。多くの科学者が「このまま開発を進めていいのか」という疑問を持つ中、オッペンハイマーはこう言って計画を強行したのだ。

「今後の戦争の抑止を考えねばならない。原爆がいかに恐ろしいものか示すために使わなければならないのだ」

しかし本音はどうだったのだろう。オッペンハイマーは科学者としてこうも残している。「技術的に見てすばらしいものを見たらまず試してみて成功させた後に初めてそれで何を成すか話し合う」まさに科学者の“性(さが)”ともいうべきものだろう。

その後の展開や影響より、まず“知りたい”が勝る…。これには生命科学を専門とする社会学者、橳島(ぬでしま)次郎氏もうなずく。

生命倫理政策研究所共同代表 橳島次郎氏

「ある物理学者と話していた時に(彼が言った)“原子核のエネルギーを解放したらどうなるか?”それは物理学者だったら絶対知りたいと思う。そういう機会が与えられれば研究に参加すると…。でもその物理学者がすぐに付け加えたのは“ただし成果について全ての情報が公開されることが条件だ”と言っていました。ただ軍事研究だとねぇ…。マンハッタン計画は完全に秘密の元でしたし…。(中略)それと完全極秘だと論文書けないでしょ。論文書けないんだったら研究してもしょうがないっていうのも科学者の普通の気持ち…」

「政治的な目的のために手段や方法を選ばない」

オッペンハイマーが直面したであろう科学者としての“性”とそれがもたらした結果への苦悩・後悔。それは現在の科学者にもあるかもしれない。なにしろ今や戦争と科学技術は切り離せない。特に第3の軍事革命と言われる“AI”は先端科学そのものであり、AIの研究者たちは現代の戦争に必要不可欠な存在になってしまっている。

そしてAIの悪用・誤用はすでに起こっている。国際人工知能管理協会の協会長に聞いた。

韓国科学技術院(KAIST)国家未来戦略技術政策研究所 チョ・サングン教授

「昨年もウクライナ戦争やガザ紛争でのAIの誤用悪用事例を見つけ論文として発表した。(中略)ロシアや中国のような権威主義国家は私たちと異なる肌感覚を持っている。彼らは政治的な目的のために手段や方法を選ばない傾向があるのでAI兵器を誤用・悪用する事例が実際に起きたことも事実だ」

中国では“官民協力”と言って民間から技術を引き出し、サイバー戦・認知戦はもとより兵站・軍事訓練までAI兵器システムを構築していると話すのは台湾のシンクタンク『国防安全研究院』の王氏だ。中国では“戦争のための科学者教育”ともいうべきプログラムが始まっている。

『国防安全研究院』王綉雯氏

「計画は4年に亘る知能武器システム実験計画で、その目標は次世代のAI兵器研究開発の専門家を育成するというものだ。基本は教育を受けた後、北京理工大学の機械工学・電子工学・AIなどの専門分野にそれぞれ進み、2人のベテラン専門家に指導を受ける。1人は学術の専門家。もう1人は国防産業の専門家だ。若者に実際の研究開発を通じて技術や経験を積んでもらうのが重要だ」

話に出た北京工科大学は軍とつながりが深い“国防七校”の一つ。倍率160倍の難関を突破した18歳以下の31人に軍民それぞれ2人の教官を付け、AIのエキスパートを育成している。さらに現在はロシアと連携し始めたという。

『国防安全研究院』王綉雯氏

「北京理工大学とモスクワ大学は深圳に中露初の合同の大学『深圳北理モスクワ大学』を設立した。両国がAI軍事応用における協力を深め、その機関を使って海外専門家のAI先進技術を吸収しようとしているのか注目している。中国のAI技術がアメリカを抜いてしまうのは恐ろしいこと…」

AI研究が進めば進むほど“歯止め”が懸念される。

西側諸国では…

2015年「国際人工知能会議」が1000人以上のAI科学者がAI兵器を警告する書簡に署名。2018年、グーグルの社員3000人以上が国防総省にAI技術を提供することに抗議。2021年「国防倫理委員会(フランス)」完全自律型AI兵器は認めない…などの動きはあるものの、遺伝子操作やクローン技術への国際的な倫理規定はまだない。

去年、国連総会でLAWS(自律型殺傷兵器システム)への対応が初めて採択されたがそれは「なんとかしなくてはなりません」というだけのもので、それでもロシア、インドなどが反対、中国、イスラエルなどが棄権するなど具体策を作るには程遠い状態だ。

「人間が暴走すればAIも暴走する」

日進月歩のAI技術にルール作りが追いつかない現実の中、“核”の管理をAIにゆだねる日が訪れるのではないかという懸念が生まれる。

生命倫理政策研究所共同代表 橳島次郎氏

「通常兵器の管理でもAIにゆだねることにも多くの国や団体が脅威だと思っている。だからこれを越えて核兵器の管理をAIにゆだねるなんてことは私は今日まで考えたこともなかったんで、それは飛び過ぎかと…」

さすがに最後の判断、いわゆる核のボタンを押すのは人間であることは揺るがないかもしれないが、そこに至るまでの過程にAIが介在していることは現状間違いない。敵が核ミサイルを発射するかもしれないと判断するための情報収集や迎撃の必要性など様々なポイントがAIにゆだねられている。

海外事情研究所長でもあり、防衛産業を専門とする佐藤丙午教授は言う。

拓殖大学 佐藤丙午教授

「そこが一番大きな問題。最後は人間が関与したとしても、情報収集の時点でAIが何らかの間違いをして人間に情報を伝えた場合、人間が最後に撃つ撃たないを判断する時、正確な情報で攻撃しているのか保障できない。となると人間の関与の仕方を広く捉えるのか狭く捉えるのか…」

番組のニュース解説、堤氏は根本的なことを語った。

国際情報誌『フォーサイト』元編集長 堤信輔氏

「AIといっても元々のプログラミングするのは人間。人間が暴走すればAIも暴走する。AIに任せようが任せまいが人間の暴走はありうる。例えば今ロシアのプーチンに起こっていることだし…。(中略)結局人間の管理に尽きる。でも強権的な国では人間の管理ができないというのがまた現実なのです」

(BS-TBS『報道1930』3月27日放送より)